杜克大學團隊發現,擴散大語言模型只需關注少量「中獎」token,就能在推理時把速度提升61-97倍,還能讓模型更懂格式、更聽話。新策略DPad不訓練也能零成本挑出關鍵信息,實現「少算多準」的雙贏。

在大型語言模型的優化中,業界通常認為計算量與模型性能正相關。

然而,杜克大學陳怡然教授團隊的一項最新研究DPad,卻揭示了一個反直覺的現象:對于擴散大語言模型(dLLMs),通過一種「先驗丟棄」策略,主動減少其計算量,不僅能帶來高達61倍的推理加速,還能意外地增強模型語境學習的能力。

這一發現源于對dLLM內部一種「中獎彩票」(Lottery Ticket)現象的洞察。模型在生成文本時,其龐大的注意力網絡中似乎隱藏著一個極度稀疏但高效的「中獎組合」。

DPad的核心貢獻就在于,它無需訓練,便能在推理時動態地、近乎零成本地找出這個組合,從而實現速度與精度的雙重飛躍。

論文作者團隊來自杜克大學CEI中心,由實習生陳欣驊、黃思韜及郭聰博士共同完成,指導教師為李海教授、陳怡然教授,其他作者還包括魏遲越、何銀濤、張健一。

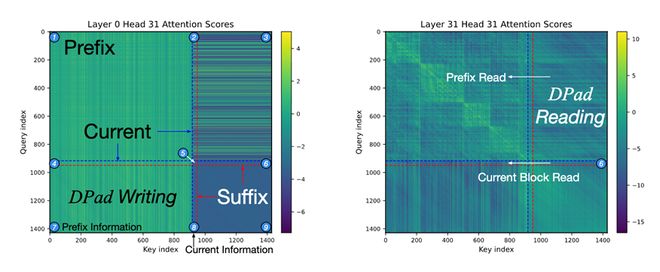

獨特的注意力機制

dLLM的草稿紙

團隊發現,dLLM的獨特之處在于雙向注意力,這使得它在生成文本時,會關注所有待生成的后文詞元(Suffix Token),并將它們用作規劃全文的「草稿紙」。

「草稿紙」機制使得模型能在Transformer的第n層往后文寫入信息,然后在第n+1層讀取后文信息,用于輔助前文的解碼。